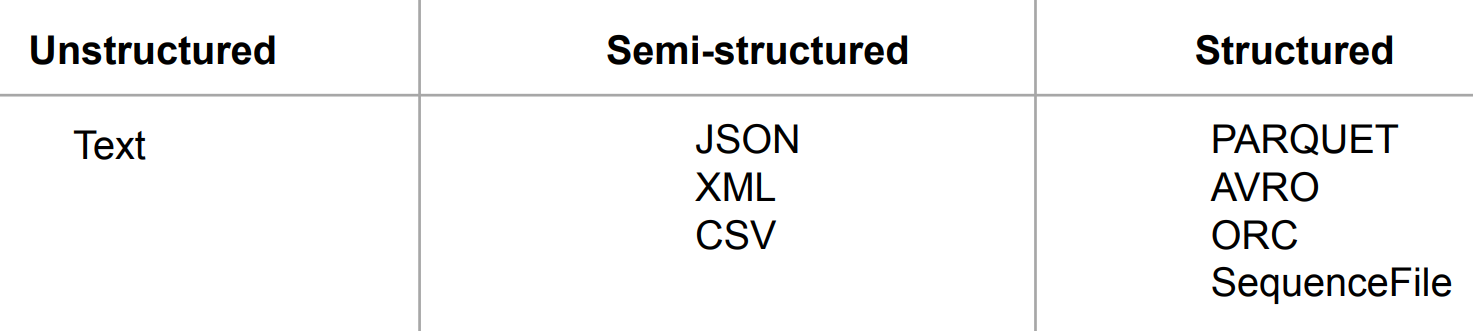

Spark의 내부동작, Spark ML, 클라우드 기반 Spark 주요 메모 사항 Spark 파일포맷 데이터는 디스크에 파일로 저장됨: 일에 맞게 최적화 필요 Spark의 주요 파일 타입 1: Y -> CSV, JSON / 압축되면 Splittable 하지 않음 (압축 방식에 따라 다름 - snappy 압축이라면 Splittable) ㄴ gzip으로 압축된 CSV, JSON 파일은 Splittable하지 않기 때문에 하나의 executor가 일단 처리하게 되며 메모리 에러가 날 확률이 높음 2: PARQUET -> Spark의 기본 파일 포맷 Parquet란? 트위터와 클라우데라에서 공동 개발 (Doug Cutting) Dataframe Write spark 세션을 spark-avro 패키지로 confi..