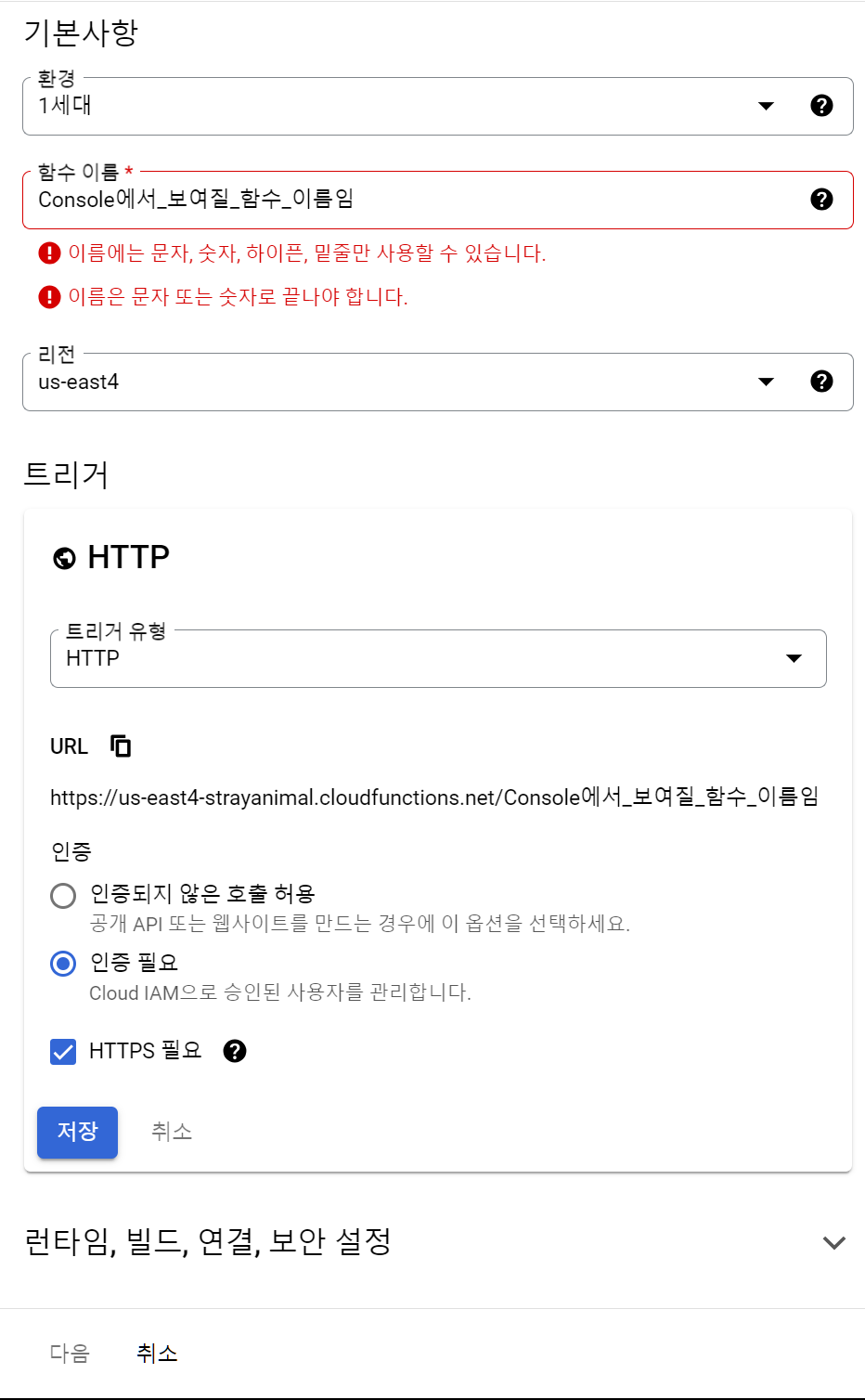

Cloud Scheduler 주요 메모 사항 이전에 작성한 Cloud Functions 함수를 crontab 처럼 스케줄링 하는 작업 이전에 작성한 Cloud Functions Google Cloud Functions로 공공데이터 openAPI를 사용해 Cloud Storage로 적재 (Python) 학습 주제 주요 메모 사항 과정을 설명하기 이전에 해당 서비스를 사용하게된 계기를 설명 프로젝트를 진행하는 과정에서 주기적으로 데이터를 가져오는 과정이 필요했었음 Cloud Functions을 사용 usiohc.tistory.com Cloud Scheduler 작성 1. 작업 만들기를 클릭 2. 작업 구성 진행 2-1 먼저 해당 스케줄러의 일정을 정의해야 한다 2-1-1. 이름과 설명을 본인에게 맞춰서 작성..