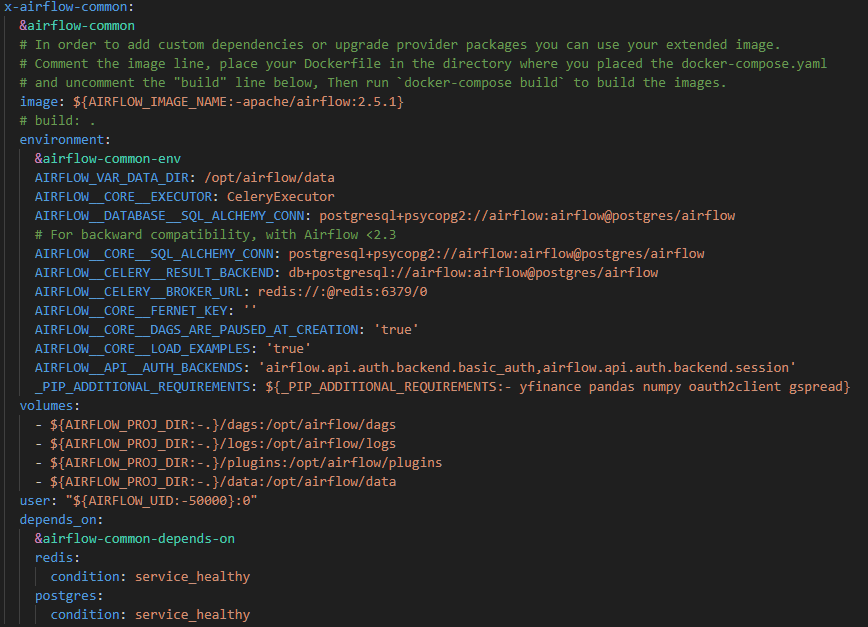

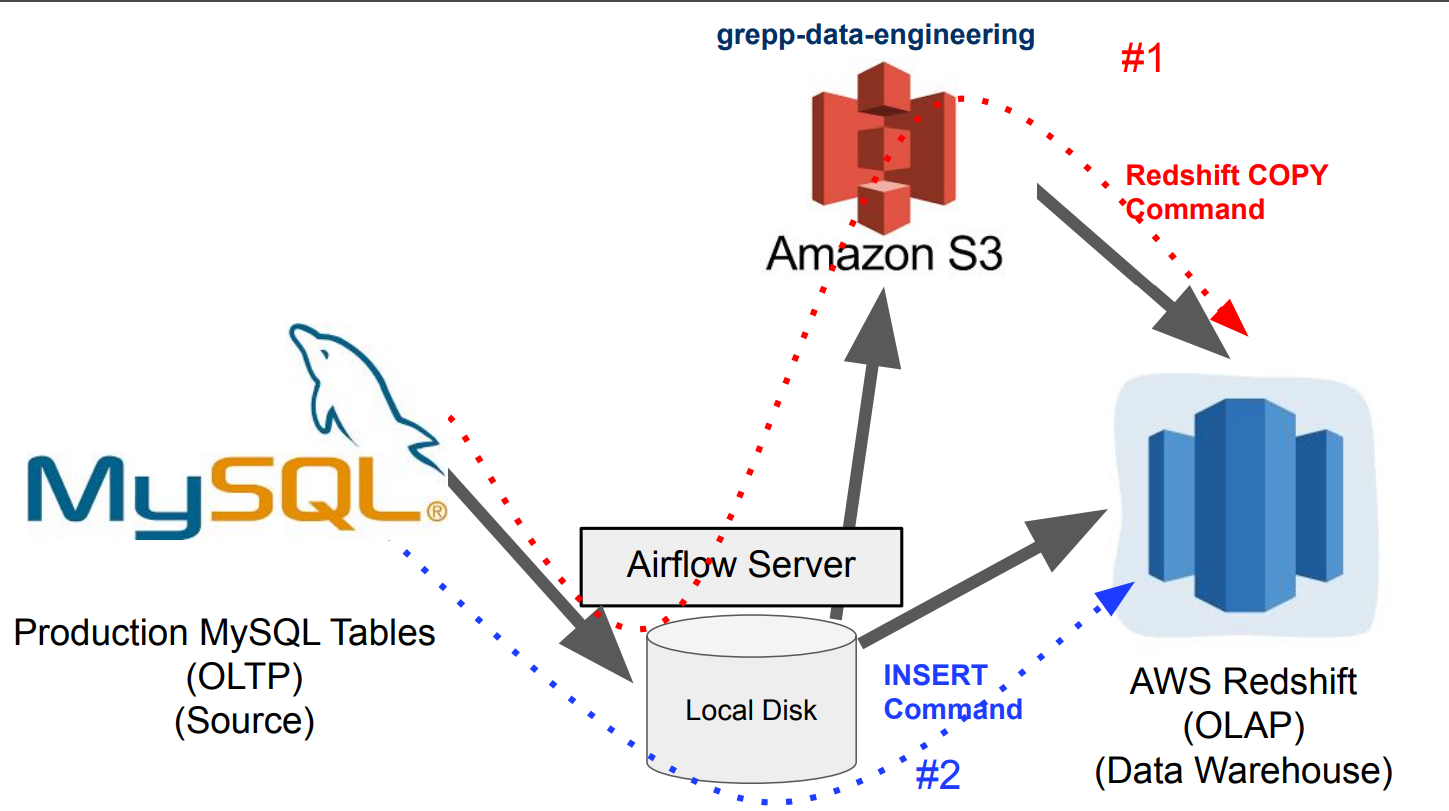

Airflow 고급 기능, dbt, Data Catalog 주요 메모 사항 ELT 작성과 구글시트/슬랙 연동 Airflow Docker 환경부터 다시 설정 이번 강의를 진행하기 전에 먼저 Docker로 환경설정부터 다시 하자 이미 learn-airflow Github repo를 다운로드받은 상황이라면 - git pull 아니라면 아래를 수행 ㄴ $ git clone https://github.com/learndataeng/learn-airflow.git ㄴ 2.5.1 이미지 관련 yml 파일 다운로드 ㄴ $ curl -LfO 'https://airflow.apache.org/docs/apache-airflow/2.5.1/docker-compose.yaml' docker-compose.yaml 수정 _PI..